ローカル環境でAIを動かすには、どんなPC構成が必要なのか?

このブログでは、「RTX3060 × Ryzen × M.2 USBストレージ」で構築した実例をもとに、ローカルAI相棒の開発記録を発信していきます。

この記事の目的と、ローカルAIを作ろうと思った理由

ChatGPTやClaudeなど、生成AIが一般にも広がったことで、AIを自分の手で動かしてみたいという人が増えてきました。

特に注目されているのが、ローカル環境で動くAIアシスタントや、自作PCで運用するLLM(大規模言語モデル)の世界です。

この世界には変態も多く、逸(脱した)般のご家庭にある様なスペックのPCを持つ人も数多くいます。

自分自身、「オンラインじゃなくても動く雑談AI」や、「画像・音楽も作れるクリエイティブAI」をローカルで構築したいという思いはあるものの、そこまで財力に余裕がある訳でもないので、安くそれなりに動かせればいいやという思いから、コスパ重視で今回のPCを組みました。

- RTX3060(VRAM 12GB)でもローカルLLMは動くのか?

- ストレージはどう運用すべきか?

- Ryzen構成でどれくらい快適に使えるのか?

この記事では、そういった疑問に答えつつ、「ローカルAIの第一歩として、どんなPC構成を組めばよいか」を軸に解説していきます。

LLMや画像生成AI(Stable Diffusion、ComfyUIなど)に興味がある方、「ローカルAIを始めたいけど、構成に悩んでる人」の参考になれば嬉しいです。

ローカルAI用PCの構成一覧と選定理由

早速ですが構成です。

今回の目標として2025年8月(記事執筆現在)でおおよそ20万円程度で快適にローカルLLMを動かすなら?というテーマで組んでみました。

| パーツ | 型番 / 内容 | 選定理由 |

|---|---|---|

| GPU | NVIDIA GeForce RTX 3060(12GB) | ローカルLLMや画像生成に必要なVRAM12GBを確保できるコスパ重視のGPUです。 現状だとメルカリで3万円から4万円くらいで購入できます。 自分はAORUSの3060ELITEw購入しました。購入理由は3ファンで冷却がよさそうなのと、 LLMブン回すなら冷却性のはあるに越したことはないので、5000円ほど相場より高くなりますけど、長く使うことを考えればなるべく3ファンをおすすめします。 |

| CPU | AMD Ryzen 5 3600(6コア12スレッド) | 十分なマルチスレッド性能のバランスが取れており、学習以外の用途でも快適です。 元々持っていたゲーミングに使ってたCPUをそのまま使っているので実質タダです。 今中古を購入するにしても1万円以下で手に入りますし、マザーボードとセット販売されている物でも2万円後半から3万円程度出せばお釣りがくるレベルです。 |

| メモリ | 32GB(DDR4) | AI処理や画像生成中の安定性を保つために最低限この容量は欲しいところです。 組んで早々に画像生成を回していますが、常にメモリ25GBくらいは平気で使うので、32GBは推奨というより最低スペックかなと。 DDR4だと大体2万円も出せば余裕かなと |

| ストレージ | M.2 SSD 2TB(USB外付け接続) | 作業ファイルの持ち運びやバックアップしやすいように、外付け型で運用しています。 SSDはアマゾンプライムセールで1.7万円、通常時でも2万円くらいですね ケースはロジテックから販売されている、LGB-PNV02UCというやつです。 実売3000円くらいで、排熱もしっかりしています。 M2 SSDは駆動時にあり得ん熱を発するので、冷却はある程度気を使ってやる必要があります。 |

| 電源ユニット | Platinum認証 1200W | 安定した電力供給と将来のGPU増設も見据えて、余裕を持たせた構成です。 これも元々使っていたゲーミングPCから拝借してきました、購入当時は3万円くらいでしたが、今はもう少しするかな? |

| OS | Windows 10(64bit) | 互換性と安定性を重視して、慣れたWindows環境です。 正直11でもいいとは思いますが(というかいま入れるならサポートの面からも11がいいと思います)この辺はお好みかなと パッケージ版で2万円弱 |

これで全部合わせて16万円くらいですね

後はモニタとかキーボードはそこまでこだわらなければそれぞれ1万円くらいで揃いますし、3060はサイズ的にも無理が無いので、5000円くらいの安いフルタワーPCケースで問題なく入ります。

余ったお金でCPUの冷却を簡易水冷に変更するもよし、1TBくらいのM.2SSDを購入してOS入れにするもよし。

大体20万円程度で組める普通のPCと言えばこんな感じじゃないでしょうか?

以下で、もう少し詳しく各パーツの話をしていきます。

④各パーツの詳細

GPU:RTX3060

ローカルでAIを動かすってなると、まず最初に立ちはだかるのが「VRAM問題」です。

VRAMが足りないとLLMは勿論、画像生成もロクに動かないです。

じゃあどのくらい必要なの?って話なんですが、自分が今実際にローカルLLM(Gemma 12B)とか画像生成を回してる環境では、VRAM12GBあれば「ほぼなんでも動く」っていう感触です。

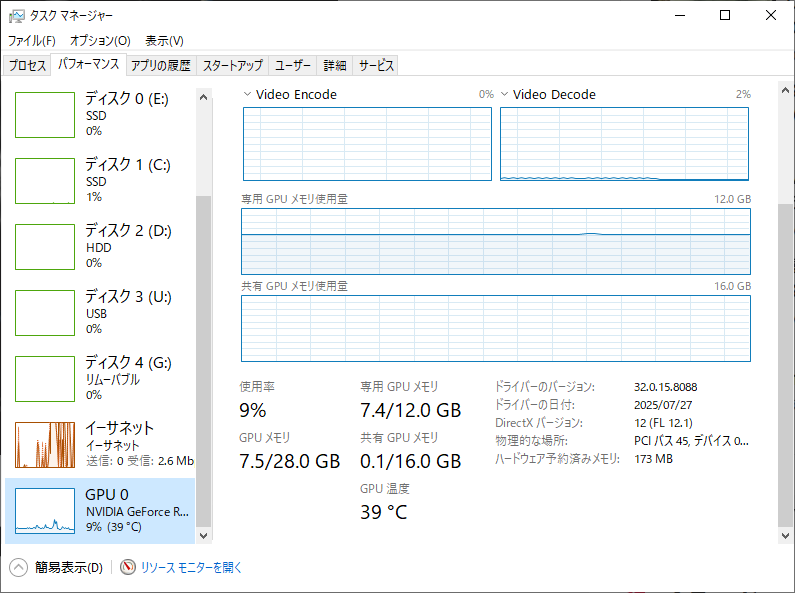

画像生成回している時にタスクマネージャーで見ていると、おおよそ7.4GBくらいのVRAM使用って感じですね。

ただ、実際に生成を始めると8GB超えますし、最終的に出力するくらいには一瞬11GBくらいまで張り付くので、やはり少なくとも12GBは欲しいかなという印象です。

LLMで言うと、Gemma12BとかMistral7Bあたりの定番LLMモデルはVRAM8GBでも動かないことはないんですが、いちいち量子化とか工夫しないと使えないし、読み込みも重たいしでわりとストレスです。

その点、RTX3060の12GBモデルは12B、13BのLLMがちょうどいいくらいです。

ガチでAI学習やる人からするとエントリーレベルなんですが、自分みたいに「ローカルで雑談AIと会話したい」とか「画像生成を好きなだけ回したい」ってレベル感なら、ほんとちょうどいい感じ。

気を付けたいのが3060でもTi付きはVRAMが少ないって事。

他にも3070とか3080も上位モデルにもかかわらずVRAMが8GBとか10GBなので(その割に高い)

上位モデルでもVRAMが少ないものがあることには要注意です。

何をどこまでやるかで変わってきますが、迷ったら12GB以上、できれば16GB以上を狙えうのがいいかなと、ボーナス後で財布に余裕がある人は3090とかを買うと幸せなんじゃないでしょうか。知らんけど。

今後は16GBが当たり前とかの時代が来るのか、LLMがより小さく賢くなってVRAM節約の風潮が来るのかはわかりませんが、2025年8月時点ではVRAM12GBのRTX3060がコスパ最強の結論でいいと思ってます。(2026年あたりにはRYX5070Tiあたりが値崩れしてくれないかなと個人的に期待しています。)

CPU:Ryzen 5 3600

CPUは AMD Ryzen 5 3600 を使っています。6コア12スレッドで、いわゆる“ちょうどいいやつ”です。

もともと自分はこれをゲーミングPC用途で買っていたので、今回はそのまま流用しました。なのでコスト的には実質ゼロ円。

ただ、今から買う場合でも中古なら1万円以下で手に入りますし、マザボとセットで2万円台の出物もザラにあるので、コスパ的にも優秀です。

性能面ですが、ローカルLLMを回すならネックになるのはVRAM(GPUのメモリ)なので、CPUにそこまでの爆速は必要ないです。

とはいえ、LLMの読み込みや画像生成の補助、ちょっとしたデータ前処理なんかではそこそこスレッド数が効いてきます。

Ryzen 5 3600は、TDPも65Wで比較的おとなしいし、Zen2世代なので現行のアプリとの相性も悪くない。しかも中古で出回ってる数も多いし、AM4マザー対応なので、パーツ流用や再構成もしやすいのが地味にありがたい。

もちろん、今から新品で選ぶなら後継の5600とか5800Xあたりも視野に入ってくるとは思いますが、価格とのバランスを考えると3600はまだまだ現役かなぁという気がします。

実際今のところはいろいろ回しててもCPUで足引っ張ってるなぁという感じはしないので、あんまりこだわる必要はないかなと。

ストレージ:M.2 SSD(2TB USB接続)

ストレージには M.2 SSD(2TB) を使ってます。しかも、ちょっと変則的に USB接続で外付け運用 してます。

なんでわざわざそんなことを…?って話なんですけど、理由はシンプルで「物理的に抜き差しして持ち運びたいから」です。

あと、自分だけのAIを持ち運べるって言うロマンのためだけにやってます。(男の子はみんなこんなの好きでしょ?)

自分の用途としては、AI用の学習データやLoRA、画像生成で使うモデルなんかを頻繁に出し入れするので、OSと分けた独立ディスクにしておきたかったんですよね。

しかもM.2 SSDってメチャクチャ早いし、USB 3.2接続なら外付けでも十分すぎるスピードが出ます。

使用してるのは 2TBのNVMe SSD。プライムセールでだいたい1.7万円、通常時でも2万円前後で買えるやつです。

ケースはロジテックの「LGB-PNV02UC」を使ってて、これがまた冷却性能が高くて優秀。

M.2はほんとに熱がヤバいので、ケース選びをミスると夏場は地獄です。

まあそもそもケース運用しなければM/BのM.2スロットに刺しておくだけでいいんですけどね、ロマンですよ、偉い人にはそれが分からんのです。

あと、物理的に分けてると「バックアップも兼ねて抜いておく」とか「サブPCにそのまま刺して動かす」みたいな使い方もできるますし、最悪災害時にも持っていけるので環境の保全もできますから、何かあったときに安心感が違います。

メモリ:32GB(16×2)

メモリは 32GB(16GB×2枚)。

AI用途であれば、これくらいが最低ラインって感じですね。

実際に使ってみると、画像生成やローカルLLMを動かしてるとメモリの消費がえげつないです。

特にComfyUIで大きめのワークフローを回したり、ローカルLLMで複数のプロセスを立ち上げたりすると、軽く25GB以上は使います。

当初は16GBでいけるかな?と思ってましたが、全然足りませんでした。メモリスワップしまくって処理落ちの嵐。

なので、今から組む人には絶対32GB推奨。できればデュアルチャネル(×2枚)で安定性も確保しておきたいところです。

ちなみに自分の構成だと、マザボ側にまだスロットが2つ空いてるので、将来的に64GBへの増設も視野に入れてます。

LoRAの学習や動画生成まで本格的に始めたら、そのときは増設しようかな、という感じです。

今回組んだPCで一番後悔しているというか、急務だなと思ったのがこのメモリ部分の増設ですね、おそらく一番初めに手を付ける箇所かなと思います。

電源・ケース・その他

このへんはもともと使ってたゲーミングPCからの流用パーツがメインです。

こだわらない人はどうでもいいと思いますが、ケースは次のパソコンにも使えるので、少しいのが欲しいって人はそれも全然ありです。

電源ユニット:Platinum認証 1200W

1200Wって聞くと「盛りすぎやろ!」って思われがちなんですが、実はLLM運用だとかなり重要だったりします。

理由は単純で、GPU使用率が常に100%近くになるから。

特にStable DiffusionやComfyUIでバッチ処理なんかやってると、瞬間的な電力ピークが結構あるんですよね。

Platinum認証の電源なら変換効率も高いし、長期的な安定運用には超重要です。

自分が使ってるのは3万円くらいで買ったやつですが、今でも全然現役。

ちなみに容量に余裕を持つのは安定駆動にはもちろん、単純に電源の寿命にも利いてきます。

常に電源がフル稼働か、40%しか稼働していないかで、コンディションが全然違ってくるので、余裕があれば電源はこだわることをお勧めします。

ちなみにこの電源、もう10年以上使ってます。

ケース:ATXミドルタワー(静音性+エアフロー重視)

ケースも流用品です。ATXのミドルタワーサイズで、フロントメッシュ+リアファン搭載のやつ。

正直、光るし静かだしで気に入ってます。

エアフローはそこそこ良好。夏場でも GPU温度は70℃前後で踏みとどまってくれてます。

ComfyUIを30分ぶん回しても、まだまだ余裕あり。

これももうすぐ変えます、HYTE Y70 Hoshimachi Suisei Limited Editionというオタク大興奮パーツの初回限定版を買えたので…(転売じゃなく、予約戦争勝ち取りました)

その他(マザボ・冷却系)

マザボはRyzen対応のB450チップセット、これも当時新品で1万円くらいで購入。

冷却はRyzen付属のリテールクーラーですが、静音化したいなら虎徹とか簡易水冷にしてもいいかも。

あと、USB接続の外付けSSDを多用するなら、USB 3.2 Gen2対応のポート数も地味に重要ポイントです。

ただ、正直この辺は動けばなんでもって感じの部分なので、あんまり気にする必要もないかもです。

実際に動かしてみた感想

結論から言うと、この構成で想像以上に快適に動きます。

もちろん、最上位モデルと比べたら速度的に劣るところもありますが、数倍の費用をかける必要は正直ないです。

LLM(gemma3など)の動作感

自分は主に Gemma 3 12B をOllama経由で動かしていますが、12BクラスまでならRTX3060(VRAM12GB)でも問題なく動作しています。

推論速度はやや控えめですが、雑談や文章生成程度なら十分快適です。

最初のロードに10〜15秒かかる程度で、あとは普通に使えます。

また、GPU温度やVRAM使用率のモニタリングもしてますが、3060なら100%近く使っても安定。

ファン音も許容範囲で、室内でもストレスなく運用できています。

ComfyUI(画像生成)の動作感

ComfyUIに関しては、1枚絵の生成ならまったく問題なし。

512×768サイズで10〜15秒前後、4Kを超える生成で60秒前後って感じでLoRAの読み込みやスケーリング調整もスムーズです。

複数枚生成(バッチ処理)や高解像度処理になると、VRAM使用量が一気に増えます。

8GBのGPUでは破綻するケースもありますが、12GBある3060ならギリギリ踏ん張れる、って感じ。

Stable Diffusion XLやControlNetも動作確認済みで、AI画像生成の学習やプロンプト検証にも十分対応できる環境です。

ちなみによく60秒を耐えられない人もいますが、むしろ普通に速くてプロンプトとか調べながらやっていたら普通に生成の方が速くて、人間の方が追い付かないのであんまり気にしなくて良いです。

ファイル管理や作業のしやすさ

外付けSSD(USB接続)に学習データやLoRA、推論キャッシュをまとめて保存しているので、データの持ち運びや別PCでの再利用もラクです。

ローカルで運用するからこそ、こういった データ管理・保守性の工夫も大事やなと思いました。

Cドライブにしかインストールできないソフトとかもあったりするので、運用上は特にこだわりとロマンが無ければCドライブ一括管理した方が楽かなと思います。

実際に使ってみて気づいたこと・今後の改善点

M.2 SSDはまじで熱い(物理的に)

外付け運用にしてるM.2 SSDなんですけど、ちょっと本気で熱を持ちます。

データコピー中とかAIのキャッシュをがっつり書き込み始めると、ケースが熱々になるレベル。

一応放熱シート付きのUSBケースを選んで正解でしたが、冷却性はもっと考えた方がいいかも。

夏場は特に、机の上のホコリも巻き込んで放熱効率落ちたりするので、ファン付きドックに乗り換えるのも検討中です。

メモリ32GBは最低ライン

これは想像以上でしたが、画像生成とLLMを並行して動かすと、32GBでも結構ギリギリ。

特にComfyUIで大きめの画像作ってると、平気で25GBとか食う場面が結構あるんですよね。

作業用にYoutubeでBGM流してたりなんかすると結構きつい場面もあります。

なので、将来的には64GBに増設予定。DDR4メモリなら安くなってるので、最初から積んどいても損はないかなと。

電源は余裕あった方が気楽

1200Wは正直オーバースペック気味ですが、将来的に4090やSSD複数構成にしたくなった時にも対応できるので、精神衛生上かなり良いです。

特にAI用途は電力の瞬間消費が大きい場面もあるので、電源容量ケチると不安定な挙動が出る可能性もあると思います。(1200Wならそんな挙動は微塵もないですが)

まとめ

ローカルでAIを動かすために、自分なりにコスパ重視で構成を組んでみました。

組んでみて初めて気づいたことも多かったですが、なんといっても「動く環境」が手元にあるのは本当に快適です。

はじめから組むとついついオーバースペックで組みがちですが、お金もかかるし、飽きた時に特大文鎮に成り下がってもらうか、冬場の暖房に使うくらいしか用途がなくなるので、とりあえず動くな…くらいのスペックで作ってみて、足りないところを増築していくくらいの方がお財布にも優しく、長く付き合っていけると思います。

ぜひこの記事を参考にして良きAIライフの第一歩を踏み出してみてください

コメント